“自己逐字敲的段落被判定 99% AI 生成,用 AI 润色的内容却被精准揪出,最后靠 AI 改写才勉强达标……” 临近毕业,大学生一帆在毕业论文 AI 检测的 “战场” 上,经历了一场荒诞又无奈的 “攻防战”。当高校用 AI 检测 AI,学生用 AI 对抗检测,这场围绕毕业论文展开的博弈,正暴露出技术与学术规范碰撞下的深层矛盾。

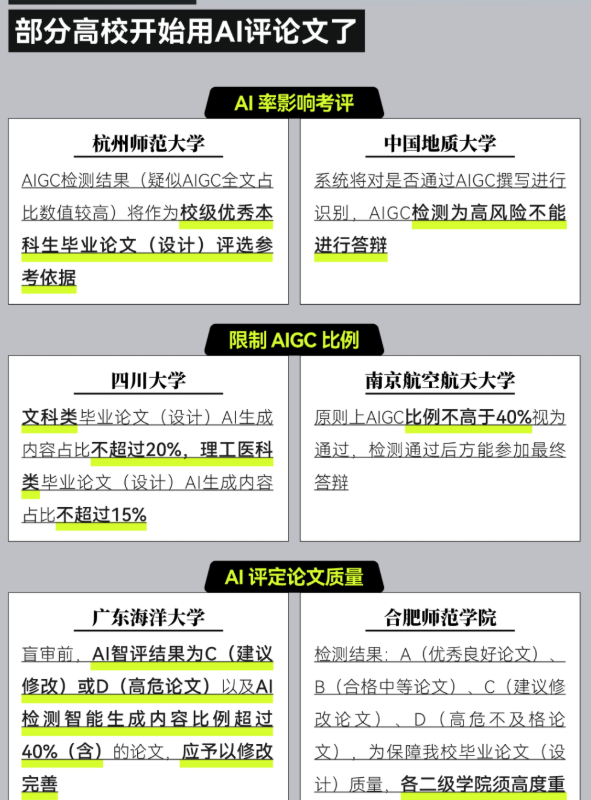

随着 AIGC 技术的普及,论文 “AI 化” 成为全球高校面临的新挑战。第三方调查显示,近三成中国大学生将 AI 用于论文写作,美国超三分之一大学生用 ChatGPT 辅助学习。在此背景下,从 2024 年初福州大学、中国传媒大学率先试水,到 2025 年西南大学、浙江科技大学等更多高校跟进,毕业论文 AIGC 检测逐渐成为毕业 “必答题”。部分高校的检测标准不断细化,福州大学将 AIGC 全文检测值限定在≤20%,且二次通过检测的论文总评仅记及格;广东海洋大学、上海海事大学等还引入 AI 智评系统,将论文质量划分为 A 到 D 四个等级,直接影响答辩与成绩评定。

然而,看似严密的检测体系,在实际应用中却漏洞百出。“查两次花 140 元,结果还不稳定”“自己写的摘要被判定 AI,引用文献也‘中枪’”,不少学生吐槽检测又贵又不靠谱。以格子达、维普、知网为代表的主流检测系统虽在 2024 – 2025 年多次升级,但检测结果依旧充满 “玄学” 色彩。有学生发现,同一篇论文间隔两小时检测,AI 特征值从 27.2% 骤降至 0.5%。更尴尬的是,检测系统将 “过于流畅” 视为 AI 特征,学生为降 AI 率,不得不删减逻辑词、把书面语改成口水话,论文质量大幅下降,“为了合格,把自己的论文改烂了” 成为众多毕业生的无奈心声。

面对这场 “猫鼠游戏”,国内外高校态度迥异。美国前 20 所顶尖高校因检测技术不成熟、误判漏判频发,普遍不建议使用;OpenAI 也指出检测器不可靠,甚至会将莎士比亚作品误判为 AI 生成。而国内检测平台对技术原理含糊其辞,训练集不公开,检测逻辑难以服众。更严峻的现实是,AI 检测技术始终落后于生成技术,简单添加拼写错误、调整文本风格就能轻松规避检测,让真正手写论文的学生反而可能因误判 “躺枪”。

当 AI 检测成为毕业关卡,却陷入 “越检越乱” 的怪圈,值得深思的不仅是技术的完善,更是学术规范与教育本质的坚守。如何跳出 “用 AI 打败 AI” 的无效内卷,让毕业论文真正回归学术价值,或许才是这场论文攻防战最该求解的答案。